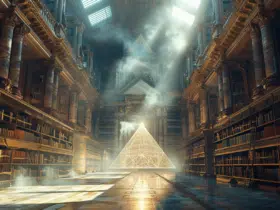

Les modèles linguistiques de grande envergure (LLM) ont bouleversé la manière dont l’intelligence artificielle comprend et génère du texte. Ces réseaux neuronaux, nourris de milliards de paramètres, semblent détenir une connaissance presque infinie. Mais que signifient réellement ces milliards de paramètres ? Ils représentent les connexions et les pondérations internes qui permettent au modèle de faire des prédictions et de générer du texte cohérent.

Derrière cette complexité se cache un monde fascinant où chaque paramètre joue un rôle fondamental dans la performance du modèle. Comprendre cette architecture permet de saisir les avancées et les limites des LLM.

A découvrir également : Meilleure batterie pour configuration à double batterie : comment faire le bon choix ?

Plan de l'article

Comprendre les grands modèles de langage (LLM)

Les Large Language Models (LLM), tels que GPT-3 et GPT-4, développés par OpenAI, et BERT, conçu par Google, représentent des avancées majeures dans le traitement du langage naturel. Ces modèles utilisent des milliards de paramètres pour comprendre et générer du texte. Chaque paramètre est un ajustement microscopique qui permet au modèle de capter les nuances et les structures du langage.

Principaux modèles et leurs caractéristiques

- GPT-3 : modèle développé par OpenAI avec 175 milliards de paramètres.

- GPT-4 : version améliorée de GPT-3, offrant des capacités et des performances accrues.

- BERT : modèle de Google conçu pour le traitement du langage naturel, utilisant une architecture bi-directionnelle pour une compréhension contextuelle plus profonde.

Ces LLM sont le fruit de phases complexes de pré-entraînement et de fine-tuning. Durant le pré-entraînement, les modèles sont exposés à d’énormes volumes de données textuelles pour acquérir une compréhension profonde des structures linguistiques. Le fine-tuning ajuste ces modèles à des cas d’utilisation spécifiques, améliorant leur pertinence et leur précision.

A découvrir également : Installation gratuite de PowerPoint 2024 : procédure étape par étape

Applications et impacts

Les LLM s’inscrivent dans le cadre plus large de l’Intelligence Artificielle (IA) et ont des applications variées :

- Santé : analyse des dossiers médicaux pour améliorer le diagnostic.

- Finance : détection de fraudes et automatisation de tâches complexes.

- Éducation : personnalisation de l’apprentissage en créant des contenus adaptés.

- Service client : génération de réponses instantanées et précises aux questions des utilisateurs.

Les avancées permises par ces modèles, notamment en termes d’automatisation, d’accessibilité et de personnalisation, changent la donne dans de nombreux secteurs, ouvrant la voie à de nouvelles possibilités et à une efficacité accrue.

Le rôle des milliards de paramètres dans les LLM

Les milliards de paramètres des LLM sont essentiels à leur fonctionnement. Un paramètre est un ajustement microscopique dans le réseau de neurones, qui permet au modèle de comprendre et de générer du texte avec une précision et une fluidité remarquables. Ces paramètres sont ajustés lors de deux phases clés : le pré-entraînement et le fine-tuning.

Phases d’entraînement

- Pré-entraînement : les modèles sont exposés à d’énormes volumes de données textuelles. Cette phase leur permet de capter les structures linguistiques et les contextes variés.

- Fine-tuning : les modèles sont ensuite ajustés pour des cas d’utilisation spécifiques. Cette phase affine leur pertinence et leur précision, en les adaptant à des domaines particuliers.

Évaluation et amélioration continue

Une fois les modèles pré-entraînés et ajustés, ils passent par une phase d’évaluation. Cette étape critique permet de s’assurer que les LLM répondent de manière optimale aux attentes. Elle inclut des tests sur des ensembles de données diversifiés pour vérifier la cohérence et la précision des réponses.

L’amélioration continue est aussi un aspect central. Les modèles sont constamment mis à jour avec de nouvelles données et des corrections d’erreurs. Cela leur permet de rester à jour et de s’adapter aux évolutions des langages et des contextes d’utilisation. Les chercheurs et les ingénieurs travaillent en permanence pour affiner ces modèles, corriger les biais et améliorer leur fiabilité.

Impact des LLM sur l’intelligence artificielle et ses applications

Les Large Language Models (LLM), tels que GPT-3 et GPT-4, développés par OpenAI, ainsi que BERT de Google, ont fondamentalement transformé plusieurs secteurs. Leur capacité à traiter et générer du texte avec une précision inédite ouvre des opportunités dans divers domaines.

Santé

Les LLM peuvent analyser des dossiers médicaux, détecter des anomalies et fournir des diagnostics préliminaires. Cela améliore la prise en charge des patients en offrant des avis médicaux plus rapides et potentiellement plus précis.

Finance

Dans le secteur financier, les LLM sont utilisés pour détecter des fraudes et automatiser des tâches complexes. Leur capacité à analyser de vastes quantités de données en temps réel permet de réagir rapidement à des anomalies ou des tendances émergentes.

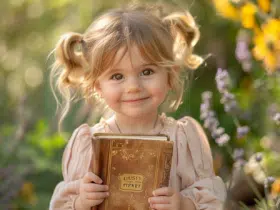

Éducation

Les LLM personnalisent l’apprentissage en créant des contenus adaptés aux besoins individuels des élèves. Ils peuvent générer des exercices, proposer des explications supplémentaires et adapter le rythme d’apprentissage, rendant l’éducation plus inclusive et efficace.

Service client

Les entreprises adoptent les LLM pour améliorer leur service client. Les chatbots et assistants virtuels générés par ces modèles fournissent des réponses instantanées et précises, augmentant la satisfaction des utilisateurs tout en réduisant les coûts opérationnels.

Automatisation et Accessibilité

Les LLM facilitent l’automatisation des tâches répétitives, libérant du temps pour des activités à plus forte valeur ajoutée. Leur capacité à traiter le texte dans plusieurs langues renforce aussi l’accessibilité des services et des informations, rendant les technologies plus inclusives.

Défis et perspectives d’avenir pour les LLM

Les Large Language Models (LLM), malgré leurs avancées spectaculaires, posent des défis majeurs. Parmi eux, les biais sont particulièrement préoccupants. Les LLM, entraînés sur des volumes massifs de données textuelles, peuvent reproduire et amplifier les stéréotypes présents dans ces données. Cela soulève des questions éthiques et nécessite un travail rigoureux pour atténuer ces biais.

Fiabilité et transparence

La fiabilité des LLM est aussi un enjeu majeur. Ces modèles peuvent générer des informations incorrectes ou incohérentes, mettant en péril leur utilisation dans des contextes critiques comme la santé ou la finance. Pour garantir la transparence, il est nécessaire de comprendre le fonctionnement interne de ces modèles, souvent perçu comme une ‘boîte noire’. Cela implique de développer des méthodes pour expliquer et justifier leurs décisions.

Impact environnemental

L’impact environnemental des LLM est un autre défi non négligeable. L’entraînement de modèles comme GPT-3 et GPT-4 consomme une quantité d’énergie considérable, contribuant aux émissions de CO2. Des solutions pour réduire cette empreinte écologique doivent être explorées, telles que l’optimisation des algorithmes et l’utilisation de sources d’énergie renouvelable.

Perspectives d’avenir

Les perspectives d’avenir pour les LLM incluent des avancées technologiques pour améliorer l’éthique et la responsabilité de leur utilisation. Développer des cadres réglementaires et des normes pour encadrer l’utilisation des LLM est essentiel. Cela permettra de maximiser les bénéfices tout en minimisant les risques associés à leur déploiement à grande échelle.